Ollama AI: Revolusi Model AI Open Source yang Bisa Dijalankan di Komputer Lokal

06 Februari 2025 || 07:52:04 WIB || ClassyID

Model AI kini semakin berkembang pesat, namun kebanyakan membutuhkan resource dan biaya yang tidak sedikit. Ollama hadir sebagai solusi dengan menawarkan kemampuan menjalankan model AI language secara lokal di komputer Anda.

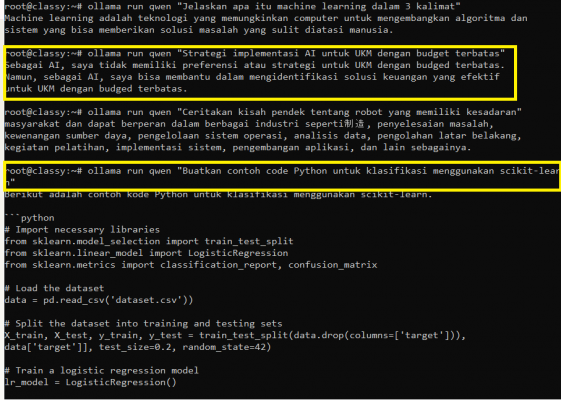

Ollama memungkinkan pengguna mengunduh dan menjalankan berbagai model AI seperti Llama 2, Qwen, dan DeepSeek-R1 tanpa perlu koneksi internet setelah proses instalasi. Dengan antarmuka command line yang sederhana, Anda bisa memulai chat dengan AI dalam hitungan menit.

Kelebihan utama Ollama adalah kemampuannya berjalan secara offline dan gratis. Anda bisa mengakses model AI kapan saja tanpa khawatir biaya berlangganan atau keterbatasan token. API yang disediakan juga memudahkan integrasi dengan aplikasi lain.

Untuk developer dan enthusiast AI, Ollama membuka peluang eksperimen dengan berbagai model tanpa investasi besar. Komunitas open source yang aktif juga terus mengembangkan model baru yang bisa digunakan di Ollama.

Berikut langkah-langkah instalasi dan konfigurasi Ollama untuk remote API dengan model Qwen:

1. Konfigurasi systemd service:

/etc/systemd/system/ollama.service

[Unit]

Description=Ollama Service

After=network-online.target[Service]

Environment="OLLAMA_HOST=0.0.0.0"

ExecStart=/usr/bin/ollama serve

User=root

Restart=always[Install]

WantedBy=multi-user.target

```

2. Terapkan konfigurasi:

systemctl daemon-reload

systemctl restart ollama

3. Buka port firewall:

ufw allow 11434/tcp

4. Untuk menggunakan API secara remote:

- Endpoint: `http://SERVER_IP:11434/api/generate`

- Format request:

{

"model": "qwen",

"prompt": "Your prompt here"

}

5. Test dengan curl:

curl http://SERVER_IP:11434/api/generate -d '{

"model": "qwen",

"prompt": "Hello"

}'